Última actualización: 14/02/2026

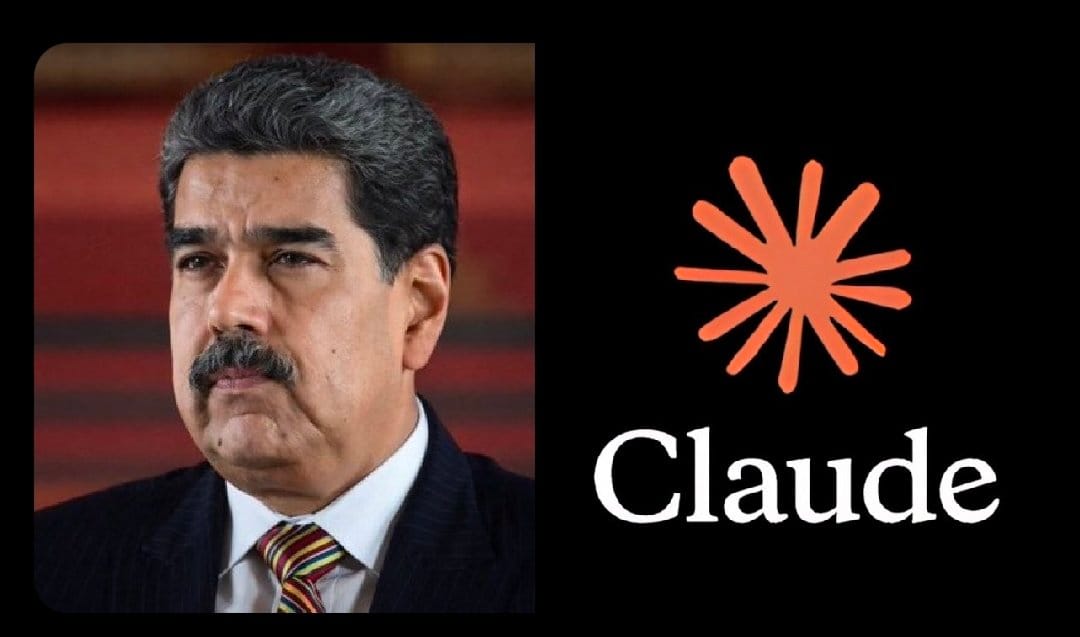

El uso de Claude en la redada a Maduro marca un punto de inflexión en la relación entre inteligencia artificial, seguridad nacional y ética tecnológica. Según múltiples informes de medios internacionales, el Departamento de Defensa de Estados Unidos empleó el modelo de IA Claude, desarrollado por la empresa Anthropic, durante la operación militar conocida como “Absolute Resolve” que culminó con la captura del ex presidente venezolano Nicolás Maduro en Caracas en enero de 2026.

Claude y la operación militar: qué se sabe

Informes del Wall Street Journal y agencias internacionales señalan que el Pentágono integró el modelo de IA Claude como parte de los sistemas tecnológicos utilizados en la operación. Aunque los detalles concretos sobre su papel específico no han sido confirmados oficialmente por el Departamento de Defensa ni por Anthropic, fuentes citadas por Reuters y otros medios indican que Claude fue accedido a través de una asociación tecnológica con Palantir Technologies, una empresa que provee plataformas de datos y análisis para el gobierno estadounidense.

La relevancia del uso de Claude en la redada a Maduro radica en que, hasta ahora, no se había documentado públicamente que un modelo de IA de gran escala se empleara en una misión militar clasificada. Se cree que el modelo apoyó diversas funciones de inteligencia y análisis, incluida la interpretación de datos en tiempo real y el procesamiento de información de imágenes satelitales, elementos críticos para la planificación y ejecución de operaciones complejas.

No obstante, la naturaleza exacta del rol de Claude sigue siendo incierta dado que las autoridades pertinentes no han divulgado públicamente detalles técnicos o tácticos sobre cómo se integró la IA en los sistemas de mando y control utilizados durante la redada.

Contexto tecnológico: Claude y la inteligencia artificial en defensa

Claude es un modelo de inteligencia artificial de lenguaje natural desarrollado por Anthropic, una empresa enfocada en construir sistemas de IA seguros y orientados a cumplir con principios éticos estrictos. La compañía ha establecido políticas internas que, en teoría, prohíben el uso de su tecnología para fines violentos, proliferación de armas o vigilancia masiva no autorizada.

La implementación de este modelo en un entorno clasificado mediante un tercero plantea varios interrogantes sobre las obligaciones contractuales, las políticas de uso de IA y la separación entre capacidades tecnológicas y ética corporativa. Anthropic y Palantir han declinado comentar públicamente sobre la participación específica de Claude en la operación, y el Pentágono tampoco ha emitido una declaración oficial que confirme los detalles de la integración de IA.

La disponibilidad de Claude en entornos militares clasificados hasta ahora ha sido única en comparación con otros modelos de IA comercial, ya que la mayoría de los principales desarrolladores —incluyendo OpenAI y Google— limitan el acceso de sus modelos a redes no clasificadas. Esta capacidad exclusiva ha facilitado que agencias de defensa integren el modelo en sistemas sensibles, aunque bajo un marco de uso que no siempre es público.

Dimensiones éticas y regulatorias

El empleo de Claude en la redada a Maduro ha encendido un debate más amplio sobre el papel de la inteligencia artificial en operaciones letales y de seguridad nacional. Por un lado, la aplicación de IA puede mejorar la precisión, la eficiencia y la capacidad de análisis en entornos de alta complejidad. Por otro, se plantean preocupaciones sobre transparencia, rendición de cuentas y límites éticos ante el uso de tecnologías que no fueron diseñadas originalmente para aplicaciones militares.

Diversos expertos en IA han subrayado la necesidad de marcos regulatorios más sólidos que definan y restrinjan explícitamente cómo se pueden emplear modelos avanzados de IA en contextos armados o en contravención de las políticas de uso declaradas por sus creadores. En este sentido, el caso de Claude puede considerarse un indicador de que la tecnología de IA se está moviendo rápidamente desde aplicaciones comerciales a funciones estratégicas estatales sin un consenso ético uniforme.

El uso de Claude en la redada a Maduro representa, según las informaciones disponibles, un hito significativo en el uso de inteligencia artificial de propósito general en operaciones de seguridad nacional de alto nivel. Aunque los detalles precisos sobre cómo se empleó Claude en la operación siguen envueltos en el secreto inherente a las misiones clasificadas, el evento pone de manifiesto la creciente integración de tecnologías de IA en funciones críticas y las tensiones que ello genera entre desarrolladores, agencias gubernamentales y defensores de la regulación ética de IA.

Te podría interesar:

- Anthropic compra anuncios publicitarios para criticar a OpenAI

- T-Mobile Live Translation: la traducción en tiempo real llega a las llamadas telefónicas

Fuentes

Esta noticia se basa en información de fuentes confiables:

- Fuente original: Reuters

- Verificación: Contenido verificado y ampliado.