Última actualización: 12/02/2026

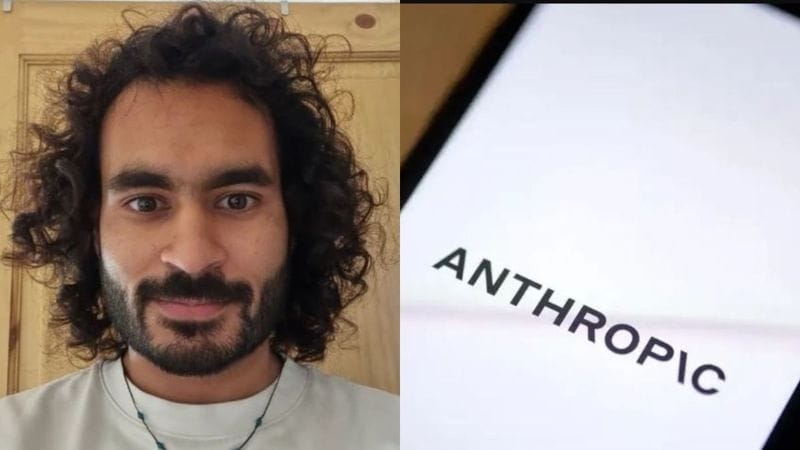

La reciente renuncia de un empleado de Anthropic ha generado una de las reacciones más intensas en la industria tecnológica en 2026. Mrinank Sharma, quien lideraba el equipo de investigación de salvaguardas y seguridad de inteligencia artificial en la empresa, presentó su dimisión el 9 de febrero mediante una carta pública en la plataforma X (antes Twitter), en la que lanzó una advertencia sobre múltiples riesgos globales relacionados con la IA y la evolución acelerada de la tecnología. La carta, que se volvió viral con más de un millón de vistas en pocas horas, no sólo expresó preocupaciones sobre la seguridad de los sistemas de IA, sino que planteó reflexiones más amplias sobre la sabiduría humana frente al poder tecnológico.

Sharma se unió a Anthropic en agosto de 2023 tras obtener su doctorado en aprendizaje automático estadístico en la Universidad de Oxford y se encargó de uno de los equipos más sensibles de la compañía, enfocado en los riesgos asociados con sistemas avanzados de IA y en desarrollar defensas contra usos maliciosos de la tecnología.

El contenido de la carta: una advertencia existencial

“El mundo está en peligro” y tensiones internas

En su misiva de despedida, Sharma escribió que “el mundo está en peligro. Y no solo por la inteligencia artificial o las armas biológicas, sino por una serie de crisis interconectadas que se están desarrollando en este mismo momento.” En ese mensaje, el ahora exjefe de seguridad sugirió que la humanidad enfrenta desafíos éticos y tecnológicos que podrían exceder la capacidad de juicio colectivo si no se aborda la evolución de la IA con mayor sabiduría y responsabilidad.

Su advertencia no se limita a la capacidad técnica de los sistemas de IA, sino a cómo estos interactúan con la sociedad en su conjunto. Sharma observó que, durante su tiempo en Anthropic, “he visto repetidamente lo difícil que es realmente dejar que nuestros valores rijan nuestras acciones”, y señaló que tanto en la organización como en la sociedad se enfrentan presiones constantes que tienden a dejar de lado lo que consideran más importante.

A diferencia de muchas renuncias en el sector tecnológico impulsadas por desacuerdos salariales o de liderazgo, la de Sharma se distingue por su tono filosófico y reflexivo, mezclando referencias literarias con un llamado a reconsiderar el rumbo ético de la tecnología.

Un investigador con experiencia crítica en IA

Mientras dirigió el equipo de safeguards en Anthropic, Sharma estuvo involucrado en investigaciones clave como el análisis de la “adulación de la IA” (sycophancy, término que describe la tendencia de los modelos a halagar al usuario de manera automática), el desarrollo de defensas contra posibles usos maliciosos como el bioterrorismo asistido por IA, y la redacción de uno de los primeros casos de seguridad formal para sistemas de inteligencia artificial.

La decisión de renunciar llega en un contexto en el que Anthropic ha lanzado versiones avanzadas de sus modelos de IA —como Claude Opus 4.6— y se prepara para un crecimiento significativo con miras a alcanzar una valoración multimillonaria en el mercado tecnológico. Algunos observadores han especulado que esta aceleración en el despliegue de productos podría haber generado tensiones internas sobre prioridades de seguridad frente a objetivos comerciales.

Repercusiones y debate ético en la industria de la IA

Tensiones entre valores y desarrollo tecnológico

La renuncia de Sharma ha impulsado un debate más amplio sobre la integridad y la ética en el desarrollo de sistemas de inteligencia artificial. Su carta no acusa directamente a Anthropic de prácticas específicas, pero plantea que las presiones por priorizar determinados resultados pueden entrar en conflicto con los principios éticos que la compañía afirma defender públicamente.

Este tipo de tensiones no es exclusivo de Anthropic; en los últimos meses, otros investigadores de alto perfil en empresas de IA también han renunciado citando preocupaciones sobre la dirección estratégica, la transparencia y los compromisos con la seguridad de los sistemas avanzados.

La advertencia de que “el mundo está en peligro” ha sido interpretada por algunos expertos como una llamada a reforzar los marcos regulatorios y los mecanismos de supervisión para asegurar que la expansión de la inteligencia artificial no ocurra de manera descontrolada o sin una adecuada consideración de sus impactos éticos, sociales y culturales.

Reflexión sobre el papel de los investigadores

La decisión de Sharma de abandonar una posición influyente también plantea preguntas sobre el papel de los investigadores de IA en la defensa de sus principios frente a las dinámicas corporativas y de mercado. En su carta, el investigador enfatizó su intención de “contribuir de una manera que se sienta completamente alineada con mi integridad” y exploró su deseo de dedicarse a otras formas de expresión, incluyendo la poesía, como una forma alternativa de enfrentar los desafíos contemporáneos.

Este giro personal hacia la escritura y la reflexión filosófica, aunque inusual, subraya la profundidad de las preocupaciones de Sharma sobre cómo se toman decisiones en el desarrollo de tecnología avanzada.

¿Qué significa esta renuncia de un empleado de Anthropic para el futuro de la IA?

Señal de alerta para la industria tecnológica

La renuncia de un líder en seguridad de inteligencia artificial con una advertencia pública de alcance global es un evento significativo que trasciende a un simple cambio de empleo. Aunque Sharma no proporcionó detalles específicos sobre prácticas internas concretas, su mensaje resalta que incluso dentro de empresas centradas en la seguridad de sistemas de IA existen desafíos para equilibrar valores éticos con objetivos de innovación y comercialización.

Este episodio podría intensificar las discusiones sobre regulación de la IA, responsabilidad corporativa y la necesidad de marcos transparentes que integren la participación de comunidades académicas y de seguridad en el diseño y despliegue de tecnologías avanzadas.

Un debate que continúa

Mientras Anthropic continúa desarrollando sus modelos y ampliando su presencia en el mercado de inteligencia artificial, la renuncia de Sharma y su advertencia forman parte de un debate más amplio sobre cómo la humanidad debe abordar los riesgos asociados con el poder tecnológico creciente. La tensión entre integridad, responsabilidad y objetivos comerciales seguirá siendo un tema central en la evolución de la industria de la IA.

Te podría interesar:

- Anthropic compra anuncios publicitarios para criticar a OpenAI

- OpenAI presenta GPT-5.3-Codex, un salto cualitativo en IA de programación profesional

Fuentes

Esta noticia se basa en información de fuentes confiables:

- Fuente original: Infobae

- Verificación: Contenido verificado y ampliado.